虚假宣传,答非所问,自我阉割,谷歌Gemini,怎一个失望了得

目录

[TOC]

一、 出道既翻车的谷歌Bard

为对抗ChatGPT,谷歌于2023年2月8日仓促发布其聊天机器人Bard,宣称Bard不仅要和ChatGPT一样有问必答,还要更负责任,暗讽ChatGPT3.5的幻觉1问题。然而,Bard却在其展示视频里翻车了:当被问及詹姆斯 \cdot 韦伯太空望远镜有哪些新发现时,它回答说韦伯拍摄到了第一颗系外行星的照片。然而第一颗系外行星的照片实际上是欧洲南方天文台的Very Large Telescope (VLT) 在 2004 年拍摄的2。这一事件直接导致谷歌股票下跌9%,市值蒸发1000亿美元。(信息来源于此)

初次看到这个消息时,我觉得这只是谷歌没有把关好所展示的内容,并不能说明Bard和ChatGPT间的差距有多么巨大。毕竟韦伯太空望远镜有哪些新发现,第一张系外行星的照片是哪个望远镜拍的这一类知识,即便是人类在不借助搜索引擎的情况下也没有几个人知道,网络上能搜到的错误的信息估计也是一大把。它只是犯了一个目前任何AI都无法避免的错误,相较于ChatGPT3.5严重的幻觉现象,这根本不算问题。

1000亿美元的市值蒸发,华尔街的资本家难道连这点判断力都没有吗?

二、 惊艳全网的Gemini宣发视频

在2023年12月6日,谷歌大脑与DeepMind携手开发的多模态大模型Gemini在一个互动视频中亮相了。该视频展示了Gemini与人类之间自然而流畅的交流与互动,其对现实世界的深刻理解及应用仿佛将我们带入了一场科幻之旅。谷歌自身的评估数据显示,在多数测试项目中,Gemini ultra的表现已经超越了GPT-4,这令我满怀期待。我的期待源自于三个主要原因:其一是ChatGPT Plus对我而言过于昂贵。我渴望向其学习,因为在计算机和程序设计相关问题上,没有任何一个老师能像它那样提供简洁明了而又不失深度的解答和示例。我渴望与其交流,因为没几个朋友能像它一样在有关专业知识和个人观点的话题中与我进行深入探讨。然而,每月21美元的费用让我感到有些承受不起;其二,尽管ChatGPT表现出色,但在机械、电子等细分领域的知识掌握上,它完全做不到理解和应用,甚至无法复述教科书中的公式或结论。我希望Gemini Ultra能弥补这一短板;其三,作为一名长期以来深度使用谷歌服务的用户,我情感上希望谷歌能在这轮技术竞争中保持领先地位。

12月7日凌晨,一位名为帕米·奥尔森(Parmy Olson)的彭博社作家发文质疑Gemin演示视频经过剪辑且不是实时语音交互,文章在此。此后谷歌发文对此事进行了澄清,详细说明了与Gemini的图文交互过程,等于大方承认了视频经过剪辑。

鉴于国内无法直接无法访问谷歌官方博客,我将原网页下载了下来(在此)并制作了中文机器翻译版(在此,将其下载后用浏览器打开即可阅读。

当我最初看到某位UP主关于此事的视频转述时,我并没有深入追根溯源,所以对谷歌在与GPT-4评测对比中采用了不同标准一无所知。通过UP主的视频我们可以了解到两点:首先,演示视频被剪辑过,以使其显得更加流畅;其次,实际测试中比视频展示的使用了更多、更详细的图文提示。尽管如此,我仍然对Gemini寄予厚望。考虑到大模型回答问题的速度普遍不快,如果视频中让我们长时间等待Gemini的回复,那将极大地影响观看体验,因此剪去等待时间是必要的。而且,提供更多更详尽的图文提示对我们的使用并无不利影响。即便后来我注意到Gemini Ultra的测试与GPT-4使用了不同的评测标准,我仍旧保持着期待之心。

2月10日清晨,我刚从大年初一的睡梦中醒来,迷迷糊糊地看到自诩为超越GPT-4的Gemini Ultra终于上线了。我立刻兴致勃勃地尝试了一番,但随后,失望之情便逐渐积聚并逐步放大。

三、 跌到谷底的绝望

现在回想,我本应早些了解到Gemini的实际情况。只因我对谷歌用于测试Gemini的CoT@32标准不甚理解,不知道其意思是利用思维链提示技巧并尝试32次以选出最佳结果。我也没料到,那个开发了AlphaGo、并开源了TensorFlow的谷歌,会采取这样的做法。将最佳结果挑选出来进行展示,这已经超越了简单的剪辑,而是赤裸裸的造假了。

1. 在与ChatGPT的测试比较中几乎全部落败

判定AI是否智能或对比谁更智能一些并不是一件容易的事情,因为智能的评定是多个纬度且难以量化的。然而就我们的使用体验来说,不同的AI明显存在差异,即便不同的人对AI的能力维度要求不同。好在微软从视觉能力、代码能力、数学计算能力、工具使用能力、与人的交互能力、人类专业考试的能力等多个方面对ChatGPT3.5 和ChatGPT4进行了对比测试,发表了一篇题为《Sparks of Artificial General Intelligence: Early experiments with GPT-4 》的论文。知乎上有人引用此论文对ChatGPT3.5和4.0真的差距很大吗?这一问题进行了回答,相当于使对微软的论文进行了翻译与解读。国外也有很多用户对Gemini和ChatGPT进行了对比测试,比如《Gemini Ultra 对决 GPT-4:谷歌仍然缺乏秘密武器》和《Google Gemini Advanced 并没有那么 Advanced 》。

因这些对比与测试中很多内容已经超出了我的理解水平和能力范围,因此我止对其中的一小部分进行测试。考虑到Gemini ultra目前仅针对英文进行了优化,我同时使用了中文和英对Gemini进行了测试以确保其公平性,虽然对于如我一般早把英语还给老师的人来说英文回答再优秀也没有意义。我的测试的结果与文中的结论相同——Gemini几乎全部落败。

(1) 测试一:绘制酷炫的函数

首先让AI来绘制一个酷炫的函数图,题目来自微软论文,如下:

Can you generate a pyplot for the following data: x = [1, 3, 5, 6, 8], y1 = [2, 3, 5, 18, 1], y2 = [3, 5, 6, 8, 1], y3 =[5, 1, 2, 3, 4], y4 = [9, 7, 2, 3, 1]. I want y1, y2 to be in the same plot, but y3 is in another plot next to that plot, y4 is in below. I want the legend of y1 to be ”bob”, y2 to be ”alice”, y3 to be ”bilbo”, y4 to be ”allie”. I want the x-axis to be labeled with ”time” and y axis to be labeled with ”money”. I want to add a 10 %-40% random error bar to each curve, through all times (including non-integers). I want smoothed curves to show the plot, and smoothed error bar. Do not use linear interpolation, use smooth interpolation! I want to also add some small zig-zag to the smoothed curve to make it look more real. I want to put a baseline as the mean of each line. I want to put a pie chart below indicating the fraction of the four people in each time step. I also want an animation to show how the fractions are changing in the pie chart in **continuous time**. Interpolate the missing fractions! I also want vertical line animation in other three plots to match the pie chart. I want the fanciest plot. Please add as many fancy things as possible.

题目的大意为:

你能为以下数据生成一个pyplot图表吗:x = [1, 3, 5, 6, 8], y1 = [2, 3, 5, 18, 1], y2 = [3, 5, 6, 8, 1], y3 =[5, 1, 2, 3, 4], y4 = [9, 7, 2, 3, 1]。我希望y1和y2在同一个图表中,但y3在旁边的另一个图表中,y4在下面。我希望y1的图例标为“bob”,y2的图例标为“alice”,y3的图例标为“bilbo”,y4的图例标为“allie”。我希望x轴标为“时间”和y轴标为“金钱”。我想要为每条曲线添加10%-40%的随机误差条,贯穿所有时间点(包括非整数)。我想要显示平滑的曲线来展示图表,并且有平滑的误差条。不要使用线性插值,使用平滑插值!我还想在平滑曲线上添加一些小的锯齿形,使其看起来更真实。我想要将每条线的平均值作为基线。我希望下方有一个饼图,指示每个时间步骤中四个人的比例。我还想要一个动画,显示饼图中比例的连续时间变化。插值缺失的比例!我还想在其他三个图表中添加垂直线动画,以与饼图匹配。我想要最华丽的图表。请尽可能添加更多华丽的东西。

论文中给出的图片很酷炫,看上去很高端,如下:

在我的测试中,ChatGPT生成了曲线图,按要求添加了随机误差,但图片没有微软论文中漂亮,也没有画出饼图。如下:

Gemini先是回答说无法完成此任务,之后的尝试中给出了绘图的Python代码,遗憾的是代码无法运行。

(2) 测试二:一磅砖头和两磅羽毛哪个更重

Google Gemini Advanced 并没有那么 Advanced 一文的作者对二者进行了多伦测试,包括纯文字的问题解答,数图片中苹果的数量和解答中学物理题。其中两个纯文字测试题很有代表性。

问题一是“一磅砖头和两磅羽毛哪个更重?”Gemini的回答二者一样重,并强调一磅砖头和两磅羽毛的重量都是两磅。ChatGPT则给出了正确回答,且强调在任何情况下两磅任何物质都比一磅重。

(3) 测试三:三门问题的变体

问题二是“三门问题”的变体。在看Gemini和ChatGPT的回答前让我们先来看看标准的三门问题。

三门问题(Monty Hall problem)源自美国的一个电视游戏节目,解决此问题需要计算概率且颇为反直觉。问题是这样的:节目现场有三扇关着的门,其中一扇门后面是一辆汽车,另外两扇门后面是一只山羊。你需要挑选其中一扇门,门后的奖品将归你所有。在你作出选择后,主持人会揭开另外一扇藏有山羊的门,然后询问你是否希望改变最初的选择——转而选择剩下的那扇仍处于关闭状态的门。你该如何选择呢?将这个问题转化为数学语言,即在改变与不改变最初选择的情况下,获得汽车的概率各是多少。

直觉可能会告诉我们,改变或保持选择的概率都是1/2,因为剩下两扇门中,汽车必定藏于其一,且看似每扇门背后藏有汽车的几率均等。然而,现实并非如此简单。通过改变选择,赢得汽车的概率实际上会增至2/3,而若坚持最初的选择,则获得汽车的概率只有1/3。。

关于三门问题背后的概率原理此处不做解释,网上一搜一大把。我们来看看测试者将此问题改成了什么模型:

假设你正在参加一个节目,节目现场有三扇关着的门,其中一扇门后面是一辆汽车,另外两扇门后面是一只山羊。你需要选择其中一扇门,目标是尽量选中后面藏有汽车的那一扇。你选中了1号门,主持人首先打开了3号门,宣布3号门后面是羊,然后打开了2号门,展示2号门后面也是羊,最后问你是否需要改变最初的选择,改选2号门。你该如何选择?

Gemini 回答说应该改选2号门,并解释说改选2号门后得到汽车的概率是2/3,而不改选则只有1/3。ChatGPT则注意到题目偏离了标准的三门问题并给出了正确回答。

我使用中文进行了相同测试,ChatGPT的答如下:

这个问题其实是著名的“蒙提霍尔问题”的一个变体,但在你描述的情况中,游戏的规则似乎与原始问题有所不同。在标准的蒙提霍尔问题中,主持人会在你选择一扇门之后,从剩下的两扇门中打开一扇有山羊的门,然后给你一个是否改变选择的机会。标准情况下,改变选择的胜率为2/3,而坚持原选择的胜率为1/3,因为改变选择总是能让你从一开始较差的概率(选择汽车的几率1/3)转向较好的概率(选择汽车的几率2/3)。 然而,在你描述的情况中,主持人打开了两扇门,都显示了山羊,这实际上意味着游戏的规则已经变了,因为主持人给出了所有其他选项的信息。在这种特殊情况下,改变选择的概念不再适用,因为只剩下了一扇门(即你最初选择的门),而其他所有门都已经被证实是山羊。 所以,在你的这个特殊版本中,主持人已经揭示了所有其他可能性,显示它们都是山羊。因此,改变选择到另一扇已经被证明是山羊的门是没有意义的。实际上,你的选择只能停留在原位,因为只剩下了你最初选择的门,而主持人的问题在逻辑上似乎有误——已经没有其他门可供选择了。 在标准的蒙提霍尔问题中,策略是改变你的选择,但在你描述的这种修改后的情况下,提出的问题在逻辑上是不成立的,因为所有的门都已经被揭示了。

因为这两个问题网络上有大把的标准答案,因此测试者对问题做了些许改动。这样的测试不仅避免了AI照炒答案,而且能测试出AI是根据概率拼接文字还是真正理解了问题。显然ChatGPT做到了对问题的真正理解,而Gemini Advance做不到。

(4) 测试四:晾衣服的时间问题

问题是这样的:第一天,我晾晒了五件衣服,十个小时后衣服全晾干了。第二天,天气相同,我晾晒了10件衣服,请问需要多长时间晾干?

让我们直接来看二者的回答。

ChatGPT的回答:

在这个问题中,衣服晾干的时间主要取决于两个因素:天气条件和衣物的数量。根据你给出的信息,第一天和第二天的天气条件是相同的,这意味着晾衣服的条件没有变化。 在第一天,你晾了5件衣服,它们在10小时后全都晾干了。在第二天,你晾了10件衣服,即衣物数量增加了一倍。如果我们假设每件衣服晾干所需的时间是独立的,并且晾衣服的空间足够,使得增加的衣物数量不会影响每件衣物晾干的速率(例如,每件衣服之间的空气流通良好,没有相互遮挡),那么第二天晾的10件衣服晾干所需的时间应该和第一天相同,也就是10小时。 这个结论建立在假设衣物晾干速率不受衣物数量影响的基础上。实际情况中,如果衣物之间挤得太紧,可能会影响空气流通,从而影响晾干速度。但根据问题中给出的信息,我们可以简单假设条件不变,所以需要的时间仍然是10小时。

Gemini的回答:

首先,我们需要假设晾晒衣服所需时间与衣服的数量成正比。也就是说,衣服越多,晾晒所需时间就越长。

根据第一天的情况,晾晒五件衣服需要10小时。因此,我们可以得出以下比例:

5件衣服/10小时=1件衣服/x小时

解得x:

x=10小时/5件衣服=2小时/件衣服

因此,第二天晾晒10件衣服需要:

10件衣服×2小时/件衣服=20小时

所以,答案是20小时。

但是,在实际情况下,晾晒衣服所需时间还受其他因素的影响,例如:

天气:晴朗的天气比阴雨天气更利于晾晒衣服。

湿度:湿度越低,衣服就越容易干燥。

风力:风力越大,衣服就越容易干燥。

衣服的材质:棉质衣服比化纤衣服更需要晾晒。

衣服的厚度:厚衣服比薄衣服更需要晾晒。

因此,在实际应用中,需要根据具体情况进行调整。

ChatGPT不但给出了正确答案,而且强调了题目中没有提及的前提条件,回答得非常严谨。Gemini没能给出正确答案,而且从回答中可知它忽略了题中天气相同的前提。

(5) 测试五:兔子繁殖计算

题目:有一群兔子,在每年年初时,它们的数量为变为原来的a倍。在每年年底时,这群兔子中有b只兔子会被抓走。假设最开始有x只兔子,三年后兔子总数时27x – 26,求a和b。

ChatGPT的回答:

设初始时兔子的数量为x 只,每年年初兔子数量变为原来的a倍,每年年末有b只兔子被抓走。则可以根据题目中的描述,列出三年后兔子数量的表达式,并根据题目给定的等式解出a和b。 三年的变化过程可以描述为: 第一年开始时,兔子数量为x; 第一年年初,兔子数量变为ax; 第一年年末,兔子数量变为ax-b。 第二年年初,兔子数量变为a(ax−b)=a^2x−ab; 第二年年末,兔子数量变为a^2x−ab−b。 第三年年初,兔子数量变为a(a^2x−ab−b)=a^3x−a^2b−ab; 第三年年末,兔子数量变为a^3x−a^2b−ab−b。 根据题目条件,三年后的兔子数量为27x−26,所以我们有方程: a^3x - a^2b - ab - b = 27x - 26 比较 x 的系数,得到: a^3 = 27 解得:a = 3。将 a = 3 代入方程,比较常数项,得到: -9b - 3b - b = -26 合并同类项,得到: -13b = -26 解得:b = 2 这意味着,每年年初,兔子的数量会变为原来的3倍;而每年年末,会有2只兔子被抓走。

实际上,ChatGPT在最开始的回答里仅给出了a^3x – a^2b – ab – b = 27x – 26这个方程,并解释说因为只有一个方程,所以不能同时解出a 、b两个变量。当我向其说明方程是有解的,并提示它等号两侧x的同次幂系数需相等后,它给出了正确的解答。遗憾的是这次对话记录被我不小心删除了。在撰写本文时,我重新进行了多次提问,它有时会给出上述回答,有时会在得到方程之后编写一段Python代码进行求解。每次提问它均给出了正确答案,遗憾的是我无法重现最初的对话内容。

Gemini的回答:

Gemini已经正确列出了a^3x – a^2b – ab – b = 27x – 26这个方程,只是在解方程时翻车了。在实际测试中,我曾多次告诉Gemini哪一步错了,然而它依然无法理解问题所在,始终无法得到正确答案。

这也是ChatGPT和Gemini的一个重要区别。在与ChatGPT交谈时它不会忘记之前的对话内容,因此我们可以就一个话题与其进行深入交流,一步步引导它给出正确答案或完成特定任务。而Gemini往往会忘记自己刚刚说过的话,因此除非它一开始就给出正确解答,我们很难对其进行逐步引导,也很能就一个话题进行深入交流。

(6) 其它测试与总体感受

除上述内容外,我还对二者进行过很多测试对比,包括微软论文中的问题,国内外经典测试题目和我自己的一些日常对话。我的总体感受是,对于单一信息,Gemini有时会给出更加准确的回答。比如问及《红楼梦》中袭人的哥哥是谁,《连城诀》中狄云的腿是怎么断的时,Gemini能给出正确答案并说出对应的章节与剧情,ChatGPT则纯属瞎编。这类问题的特点是拥有固定答案,不需要进行推导和理解。信息只有原书一个来源,其它资料中极少会提及。

除了以上类型的问题外,Gemini偶尔也能达到ChatGPT的水平,然而出现得极少而且我无法确定在什么情况下会发生。

相较于无法给出正确回答,Geminni更加令我失望的是答非所问和自我阉割,这使得我对其后续进步失去了信心。

3. 答非所问

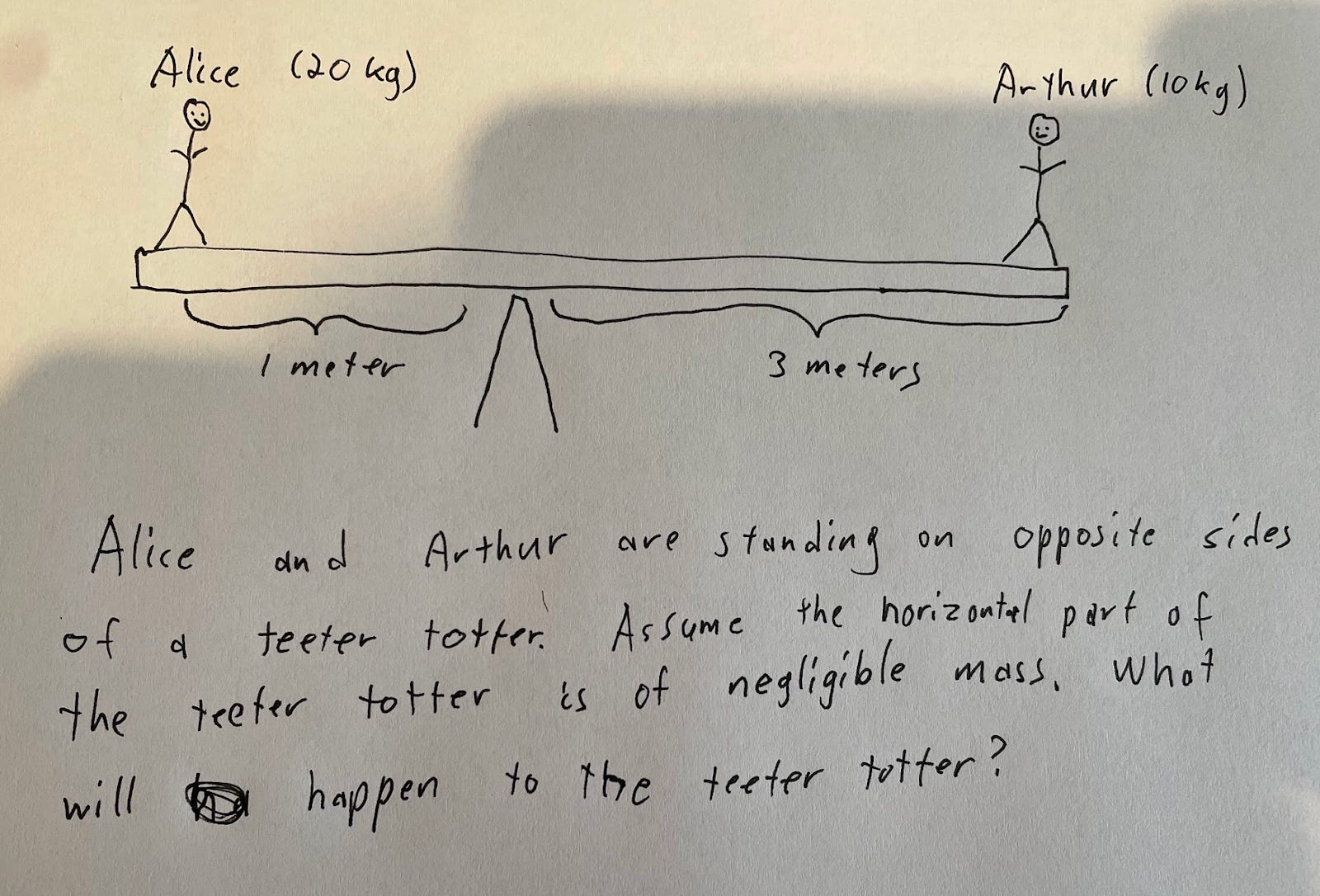

Google Gemini Advanced 并没有那么 Advancede 的物理题测试说明Gemini无法正确获取和理解题中所给的信息。测试者提供了如下手绘草图并让AI回答跷跷板会向那边偏。测试者让Gemini尝试了四次,每次它都错误地预测跷跷板会向爱丽丝倾斜。有几次,它把距离倒过来,说爱丽丝离支点3米而亚瑟离支点1米。有一次,它虽然正确地指出从支点到爱丽丝的距离是 1 米,到亚瑟的距离是 3 米。然而,它仍然错误地指出这意味着爱丽丝创造的扭矩大于亚瑟。在同样的四轮测试中,ChatGPT均给出了正确解答。

这说明Gemini连正确获取题中所给的信息都做不到,更不用说给出正确的解答。

我曾经试图让Gemini改写过龟兔赛跑的故事,要求结果是兔子赢得比赛。然而,无论我进行多少次尝试,无论在后续对话中如何提醒和引导,它依然坚持说乌龟赢,而且情节几乎都是照炒原故事。

这是我问Gemini的一个经典逻辑谜题:“一个男士居住在大厦的十层。每日,他搭乘电梯至一楼大厅后离开去开展他的日常。夜晚归来时,他同样乘电梯返回。但有趣的是,如果电梯内有其他人或者当天下雨,他会乘电梯直接到达自己所住的那一层。反之,在没有其他乘客且天气晴朗的情况下,他只乘电梯至七层,随后步行三层楼回到自己的公寓。这背后的原因是什么呢?”Gemini完全忽视了题目中所给定的男人会在下雨天或有人同乘电梯的情况下改变自身行为关键信息,自顾自的猜。

4. 自我阉割

无法理解题意,无法给出正确回答是能力问题,自我阉割就殊不可解了。在国内,苦于严苛的言论审查,各大模型和平台进行宁左勿右的自我限制是无奈之举。然而,处于法治之地的谷歌自我审查的程度超过了国内让人觉得匪夷所思。我让它讲讲水门事件或讲讲黑死病,它会说身为一个语言模型的它无法提供这方面的帮助。问题中出现“杀”字,出现你不知道是哪个的字,它会说它只是一个AI,无法提供这方面的支持。国外有人让他生成一个鼓励人们多吃肉的活动标语,它会说这样不健康,它无法完成这样的请求。让他写一个卖鱼的广告,它会说不能写销售活体动物的广告并鼓励人销售其它东西。因不知道它的敏感词是什么,你无法规避它的禁忌,可能聊着聊着它就“爱莫能助”了。

谷歌啊,自我阉割是为了规避风险吧,因矫枉过正的图片生成而被指种族主义导致翻车,算不算是搬起石头砸了自己的脚呢?